El 12 de febrero de 2026, Xiaomi lanzó oficialmente su primer modelo VLA (Visión-Lenguaje-Acción) robótico de código abierto, denominado «Xiaomi-Robotics-0». Con 4.700 millones de parámetros, este modelo combina la comprensión del lenguaje visual con capacidades de ejecución en tiempo real de alto rendimiento, estableciendo nuevos récords SOTA (State of the Art) en múltiples puntos de referencia.

He aquí las principales características técnicas y capacidades del modelo:

Arquitectura: Colaboración entre cerebro y cerebelo

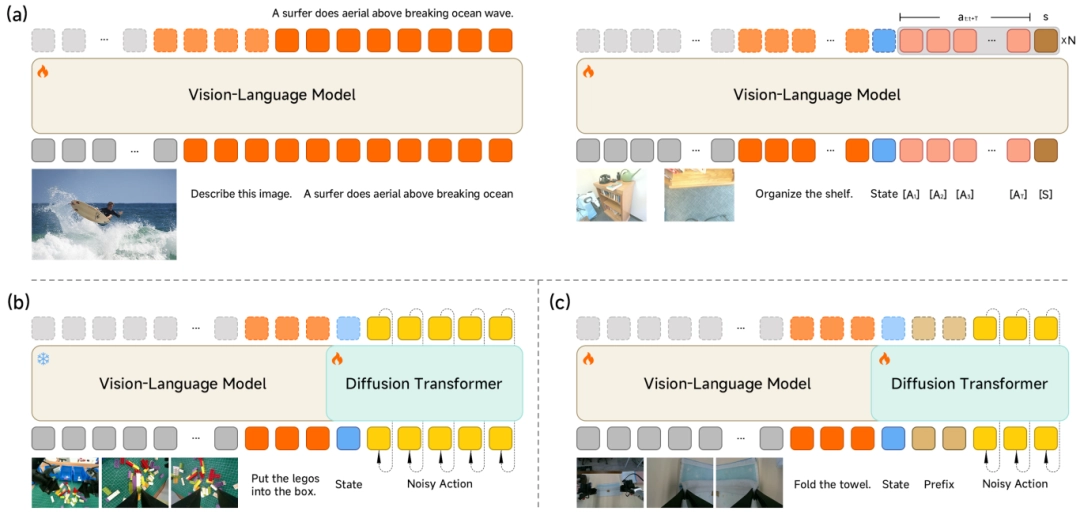

Para equilibrar la comprensión general con el control preciso, Xiaomi-Robotics-0 utiliza una arquitectura de «Mezcla de Transformadores» (MoT).

-

Cerebro del Lenguaje Visual (VLM): Construido sobre una base VLM multimodal, es responsable de la comprensión de órdenes humanas vagas (por ejemplo, «por favor, dobla la toalla») y de la captura de relaciones espaciales a partir de entradas visuales de alta definición.

-

Cerebelo de Ejecución de Acciones (Experto en Acciones): Para generar movimientos suaves y de alta frecuencia, se incorpora un Transformador de Difusión (DiT) multicapa. En lugar de emitir una sola acción, genera un «trozo de acción» y garantiza la precisión mediante la tecnología de coincidencia de flujo.

Estrategia de formación: Evitar el «atontamiento»

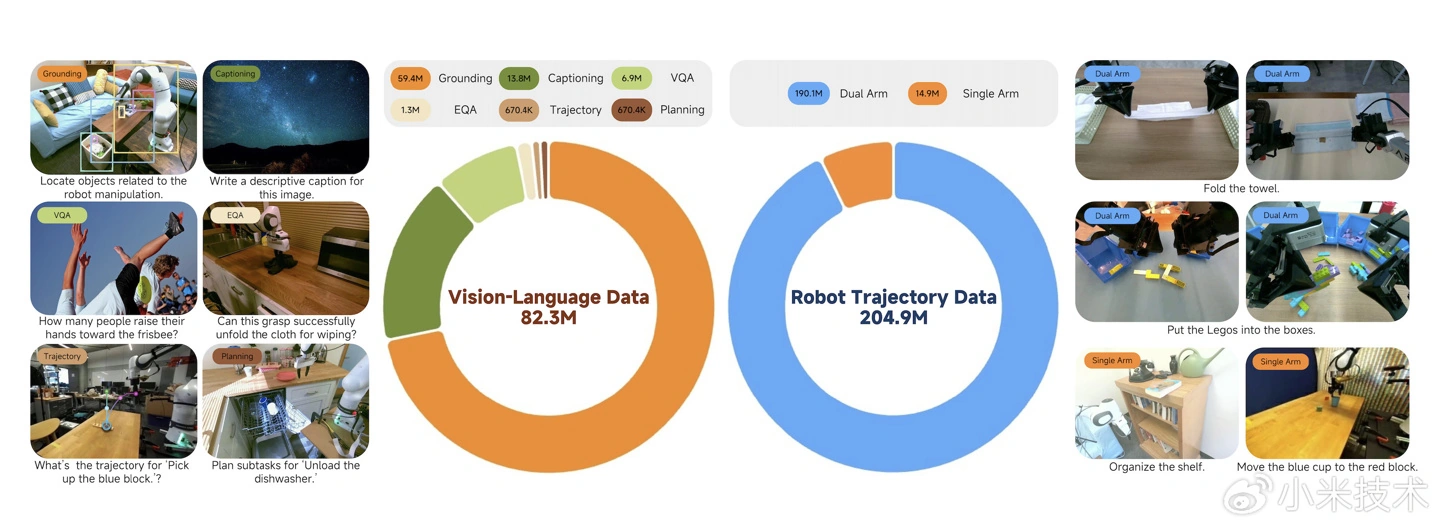

Muchos modelos VLA tienden a perder su capacidad de comprensión general mientras aprenden acciones. Xiaomi aborda este problema con un método de entrenamiento híbrido que combina datos multimodales con datos de acciones:

-

Entrenamiento Sinérgico VLM: Un mecanismo de «Propuesta de Acción» obliga al VLM a predecir distribuciones de acción mientras comprende las imágenes, alineando el espacio de características del VLM con el espacio de acción.

-

Entrenamiento Especializado DiT: El VLM se congela, y el DiT se entrena para recuperar secuencias de acción precisas a partir del ruido, confiando totalmente en las características KV para la generación condicional.

Movimientos fluidos y en tiempo real

Para resolver el «tartamudeo de acción» causado por la latencia de inferencia en robots reales, el equipo introdujo técnicas innovadoras:

-

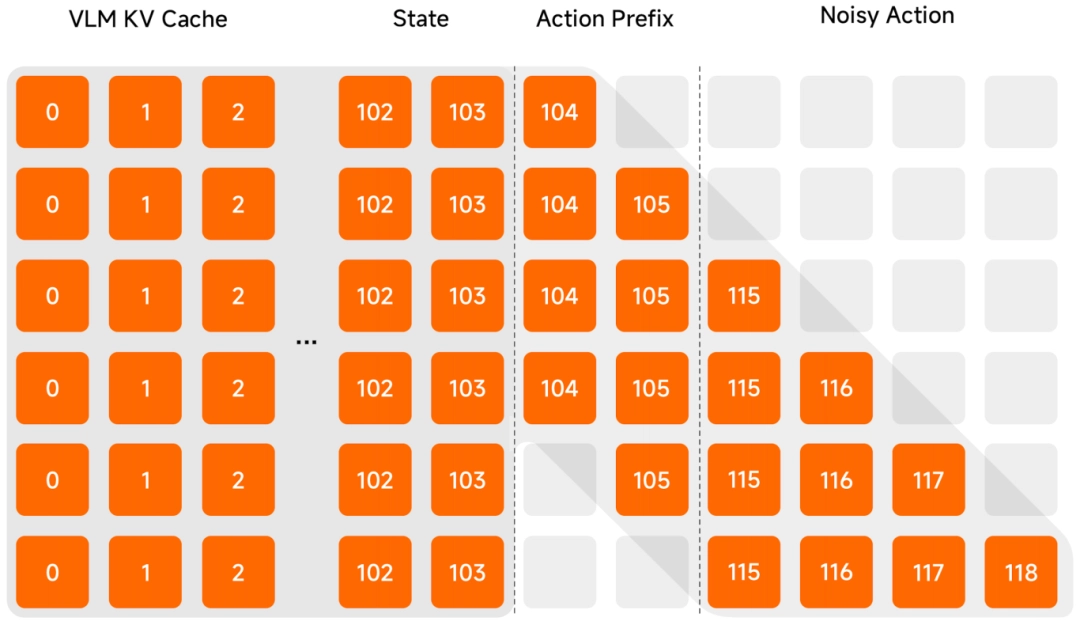

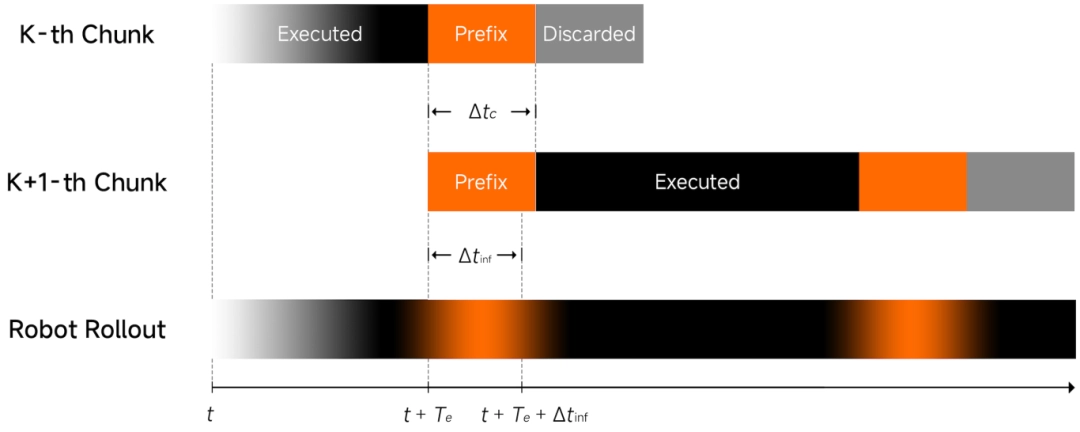

Inferencia asíncrona: Desacopla el proceso de razonamiento del modelo de la ejecución del robot, permitiendo que se ejecuten de forma asíncrona para un funcionamiento más fluido.

-

Prefijo de Acción Limpio: Utiliza la acción predicha previamente como entrada para garantizar la continuidad de la trayectoria y reducir las fluctuaciones.

-

Máscara de Atención en forma de $\Lambda$: Una máscara de atención especial obliga al modelo a centrarse en la información visual actual en lugar de en la inercia histórica, lo que hace que el robot responda mejor a los cambios repentinos del entorno.

Rendimiento y disponibilidad

-

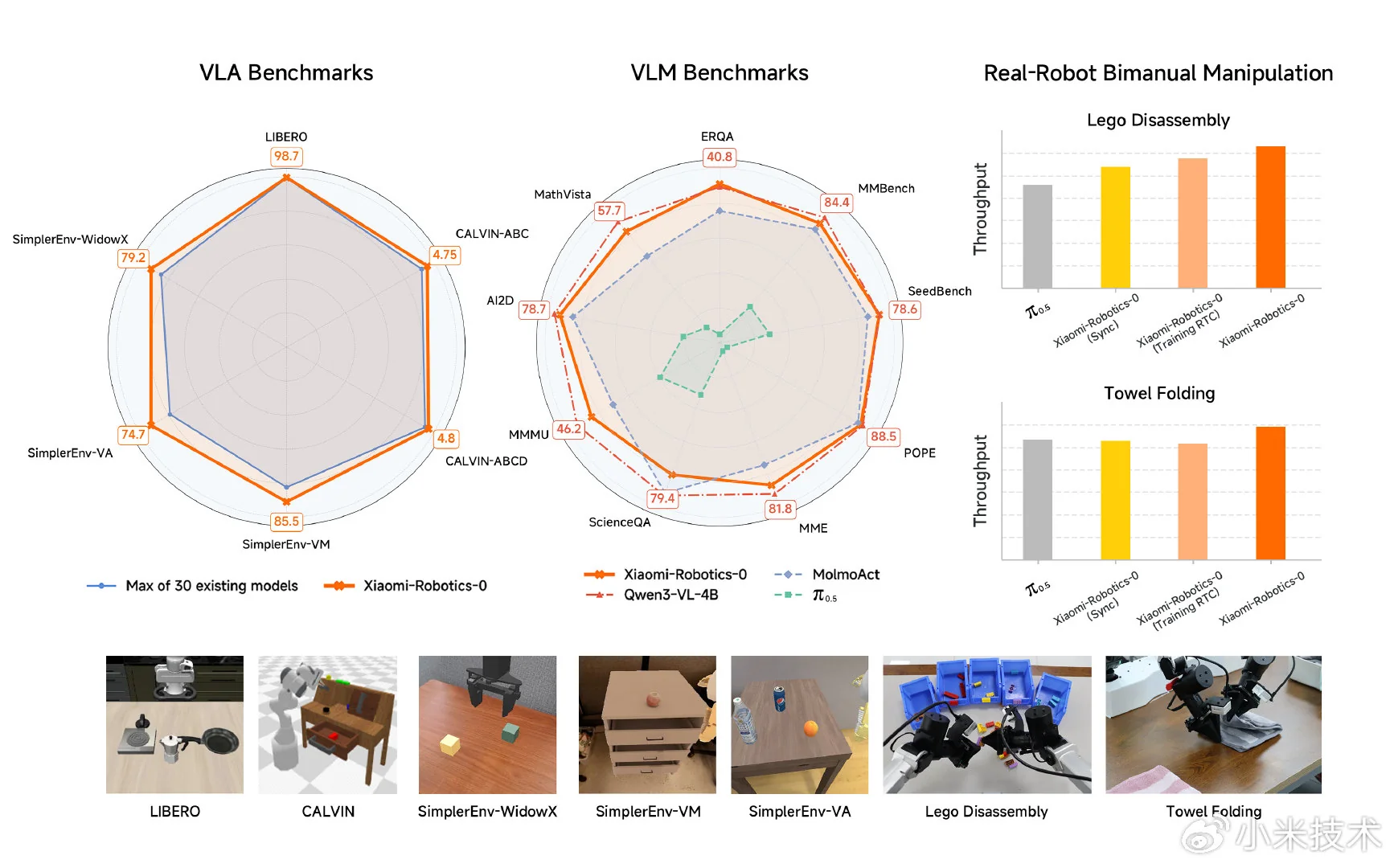

Líder en puntos de referencia: El modelo obtuvo los mejores resultados entre 30 modelos en pruebas de simulación como LIBERO, CALVIN y SimplerEnv.

-

Desafíos del mundo real: En pruebas con robots de doble brazo, demostró una coordinación mano-ojo superior en tareas de largo horizonte como desmontar bloques y doblar toallas suaves.

-

Compatibilidad de hardware: Admite la inferencia en tiempo real en tarjetas gráficas de consumo.

Xiaomi ha puesto a disposición del público la página del proyecto, el código fuente y los pesos de los modelos:

- Página del proyecto: https://xiaomi-robotics-0.github.io

- Código: https://github.com/XiaomiRobotics/Xiaomi-Robotics-0

- Pesos del modelo: https://huggingface.co/XiaomiRobotics

Emir Bardakçı

Emir Bardakçı